玩个锤子,李飞飞夫妇团队的最新研究

编者按:本文来自于微信公众号 “量子位”(微信公众号:QbitAI), 动点科技经授权发布。

锤子是一个神奇的工具,各种画风都能驾驭。

比如,神族玩锤子是这样。

兽族玩锤子是这样。

人族嘛……

误。

回归正片,今天来看看,机器人玩(个)锤子,且是自学成才,会有怎样的画风?

今天的机器人主角,诞生在斯坦福李飞飞夫妇的实验室里,拥有花样锤技,还被机器人顶会RSS 2018选中了。

关于锤技,先看两个小栗子。

任务一:把钉子敲进木盒

人类只告诉机器人这个任务,没有其他多余的指示。使用什么工具,用什么姿势完成,全靠机器人自己判断。

它发现了桌上的一把锤子。

于是,抓起锤子的把手,把钉子敲了进去。

完成。

任务二:清除桌面的易拉罐

同样,人类只告诉机器人这个任务,没有其他多余的指示。使用什么工具,用什么姿势完成,全靠机器人自己判断。

于是,它又抓起了桌上的锤子。

同样完成。

注意,两个不同的任务,握锤姿势不一样(不一样……)

这个机智的机器人,能够根据不同的任务,决定应该如何握住手里的锤子,以及用什么方式完成指定的任务。

这个机智的机器人,能够根据不同的任务,决定应该如何握住手里的锤子,以及用什么方式完成指定的任务。

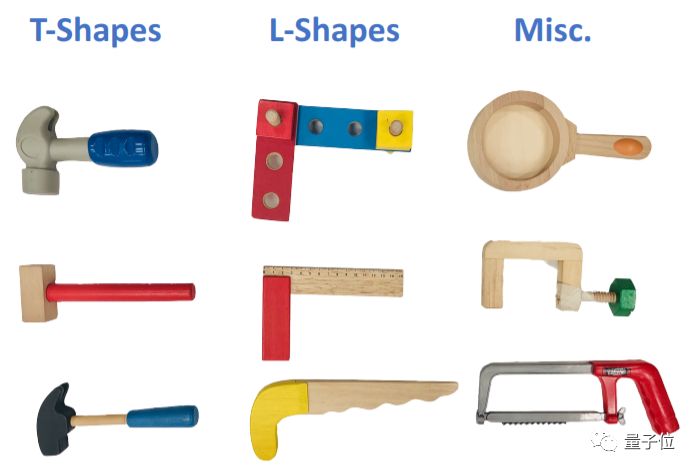

其实,就算是它从来没见过的、骨骼清奇的锤子,也是一眼就会玩。

锯都算上了,但这也只是很小的一部分。

而且,机器人脑子里的神经网络,是自我监督学习的,不需要人类传授什么秘籍。

这只为了任务定制抓取姿势的机器人,是如何修炼成仙的?

先审题,再行动

从前的机器人,大多是用保守的方式抓取工具——抓质心最稳。

简单粗暴,但这并不一定适合它下一步要完成的操作。

毕竟,钉子要完全敲进去,易拉罐要掉下桌面去,才算成功。

所以,抓取的牢固程度,与适合任务的程度之间,需要一些妥协。

为了让机器人,在执行任务的时候更有针对性,斯坦福团队制定了四步方略如下——

一是,机器人要懂得,人类希望的结果是什么。

二是,机器人要识别物体的特征,知道它是好用的工具。

三是,找到合适的抓握方向,才能更有效地做任务。

四是,去吧,皮卡丘。

知之为知之,审题真的有用。

神经网络两步走,一抓取二操作

(^∀^*) 机器人:

咦,任务是扫桌

咦,锤子长这样

咦,这姿势不错

咦,易拉罐没了

为了让机器人选择正确的姿势,执行特定的任务,团队设计的神经网络结构,也并非一步登天。

这个名叫TOG-Net的神经网络,可以同时训练两个模型——

一是抓取模型,二是操作模型,对应每个任务 (锤击/扫除) 的两个阶段。

优秀的抓取姿势,是任务成功的一半。

给神经网络输入一幅图,它就会提出几种抓取姿势。

抓取模型会为每个姿势算出一个分数,代表抓取质量。

选择分数最高的一种姿势,给机器人去执行,并且把这个姿势发送给操作模型。

这样一来,系统就能根据已经采取的动作,来规划后面的动作。

步步为营。

虚拟的训练,现实的测试

神经网络不是直接在真实世界里训练的,而是在一个名叫“Bullet (子弹) ”的开源物理模拟器里训练的。

虚拟世界里,机器人可以尝试无数次失败,修炼出锤子的使用技能。

虽然,团队也在思考,是不是直接进三次元修炼,也会同样有效。

模拟器可以生成大量的模拟数据。

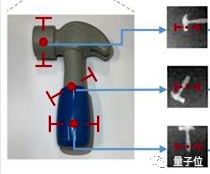

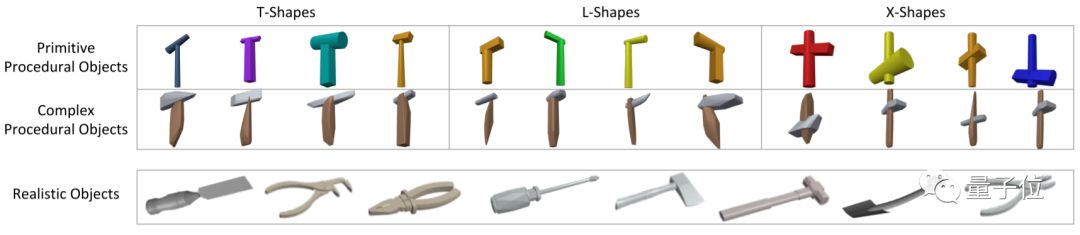

比如,这样那样的锤子。大体分为三类,T型、L型、X型。

当然,现实更复杂,所以,混合型也要包含进去。

除了工具之外,抓取姿势的数据也非常重要,难点也在这里。

因为,姿势采样的时候,抓握的点大多集中在工具的长边上。许多姿势之间,距离都非常小,太相似了,多样性又不够。

于是,团队用了物体识别中,常见的非极大抑制 (NMS) 方法,去除了一些与高分姿势非常相近的姿势。

这样,训练集里面的姿势各不相同,对训练来说更有力。

另外,自我监督学习机制,会用每一次抓取成功和任务成功的标签,来指导训练过程。

当然,模拟器终究是模拟器,最后还是要把训练成果搬到现实里来。

三次元里,机器人的夹具,是依靠深度摄像头的点云来工作的。

像这样,稍稍超出常理的“锤子”,机器人还会给它转体180度,再扫掉易拉罐。

驾轻就熟。

成果,万变不离其宗

其实,来这里的路上,各位已经陆陆续续看过一些测试的效果了。

不过,还是要强调,以下这些锤子,机器人在训练的时候,都没见过。

T型锤的扫除玩法。

L型锤的敲钉玩法。

混合锤,就是刚才那只绿色脑袋的奇怪物体,再出现一次。

隐隐感觉,机器人看到这样不科学的工具,还是有些情绪。

不过,内心戏放在一边,研究人员对AI和机器人一起做的任务,还是很满意的。

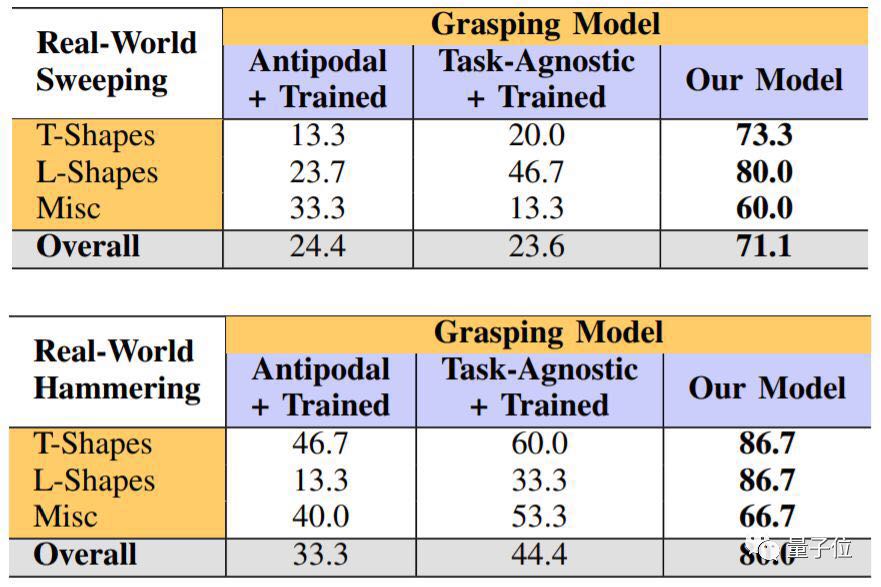

除了直观地看出,碾压了某不知任务的算法,数据也很硬——

不管锤子是T型,L型,还是奇型。

也不管任务是锤击,还是扫除。

成功率都比忽略任务的同行,高出许多。

实验室里的人类们

这项研究的团队主要来自斯坦福计算机视觉与学习实验室(SVL Lab),包括李飞飞、Silvio Savarese,和他们的学生们。

论文的第一作者房宽是斯坦福大学读博士,师从Silvio Savarese。在进入斯坦福大学之前,他在清华大学读完了本科,当时曾经在微软亚洲研究院机器学习组实习。

房宽在个人主页上透露,去年夏天,他是在Google [X] Robotics度过的;而今年暑假,他要去Google Brain实习了~

其他几位作者也都来自斯坦福大学,其中二作Yuke Zhu和Animesh Garg都是李飞飞和Savarese的学生,而Andrey Kurenkov师从Silvio和Ken Goldberg。

而最后两位作者,也就是指导这项研究老师们,你们应该都很熟悉啦。

一位是计算机视觉界的国民女神李飞飞:

另一位,是她的丈夫,同是斯坦福大学副教授的Silvio Savarese。

不知道这张实验室全家福里,有没有你熟悉的身影:

传送门

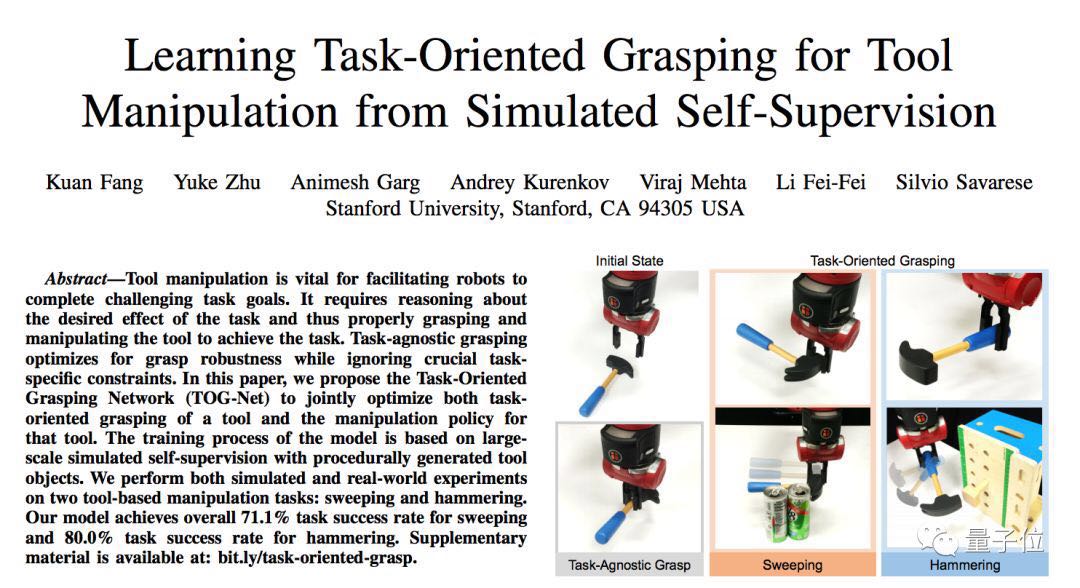

Learning Task-Oriented Grasping for Tool Manipulation from Simulated Self-Supervision

Kuan Fang, Yuke Zhu, Animesh Garg, Andrey Kurenkov, Viraj Mehta, Li Fei-Fei, Silvio Savarese

https://arxiv.org/abs/1806.09266