幽默感不仅是一种与思维发展相联系的情绪体验,其本质也是一种创造力。因而,无论是段子或是梗图都是创意性劳动成果的呈现。曾有预言指出,创意性工作是最难以被AI取代的工作。但随着AI大模型的不断发展与迭代,这种固有印象似乎将很快被打破。

从基于模式和结构的纯文本式的笑料,到基于图像理解和要素提取的吐槽,AI随处释放的幽默感背后是多模态大模型点滴进阶的缩影。但取代纯文本创作的段子手,绝不是AI的核心竞争力和最终目标。

未来,AI不仅能写段子,大概率还能讲会演。即便暂时无法代替真人进行现场表演,但假以时日,生成真人脱口秀表演的视频将不成问题,而这对于花重金邀请喜剧大咖进行专场直播和录制的奈飞来说绝不是个好消息。当带着审视目光的观众最终一个个被AI戳中笑穴时,喜剧从业者们脸上的表情也必定耐人寻味。

“行活”水准的吐槽文本

幽默感通常被定义为对于一事物的诙谐、滑稽或不合逻辑的理解和表达力,这需要人类具备情感、经验和文化背景等因素的综合作用。

正如很多脱口秀演员的早期生涯都是从模仿前辈开始,在对语义的理解和模仿的基础上,AI已经能输出完全贴合不同喜剧大师风格的段子。

例如,在GPT-4对人类笑话段子的理解测试中发现,其能正确解析英语、西班牙语、日语等语言中的谐音梗,能看懂双语梗和原创梗。

通过对不同演员的多个经典单口喜剧专场的文本训练,GPT-4可以精准模仿乔治卡林、路易CK、Joan Rivers、Kevin Hart、Chris Rock等单口喜剧演员的风格进行脱口秀文本创作,其创作思路、用语习惯与其模仿对象高度神似,经专业人士认证已经能达到通顺平稳的喜剧工业流水线水平。与同样水准的脱口秀编剧相比,GPT-4的优势还在于其可以高密度批量稳定输出,并按需求不断修改。

这意味着,若将GPT-4外接语音助手,用户将轻松获得足不出户即可收听业界中等水平的原创脱口秀专场的体验。

除了“文生文”,看图说话也是AIGC的看家本领之一。

最近,一款由网友制作的“meme梗图生成器”风靡外网。用户上传随手拍摄的照片,程序将自动识别图片并配上调侃文字,并一键生成梗图,其讽刺而不失风趣的风格令众多初次尝试的用户欲罢不能。令人惊叹的是,即便针对同一场景进行多次拍摄上传,生成器也会敬业地给出完全不同但同样辛辣有质感的吐槽文案。

“图生文”模型的顶级性能展现

GPT-4是由OpenAI潜心研发的大模型GPT-3.5的迭代版,其在自然语言处理方面的高度优化使其可用于从故事脚本、角色创作到游戏内容创作的所有领域。OpenAI论文显示,GPT-4已经能够理解图像中的逻辑和其中的幽默感。

而前文中另一个展现AI幽默感的工具——梗图生成器则是集成了GPT-3.5的文字生成能力和另一个视觉语言训练模型BLIP图像识别能力的成果(最终呈现的效果是用户上传的原图叠加AI生成的吐槽文字)。

2022年,Saleforce亚洲研究院的高级研究科学家Junnan Li提出了BLIP(Bootstrapping Language-Image Pre-training)模型,与传统的视觉语言预训练(vision-language pre-training)模型相比,BLIP模型统一了视觉语言的理解和生成,能够覆盖范围更广的下游任务。

BLIP基于编码器和解码器的多模态混合,可以与三个视觉语言目标共同进行预训练,即图像-文本对比学习、图像-文本匹配和图像-条件语言建模。通过对噪声图像和文本对比学习,BLIP模型能够在各种下游任务上取得了稳定的性能改进,包括图像-文本检索、图像标题、视觉问答、视觉推理和视觉对话。

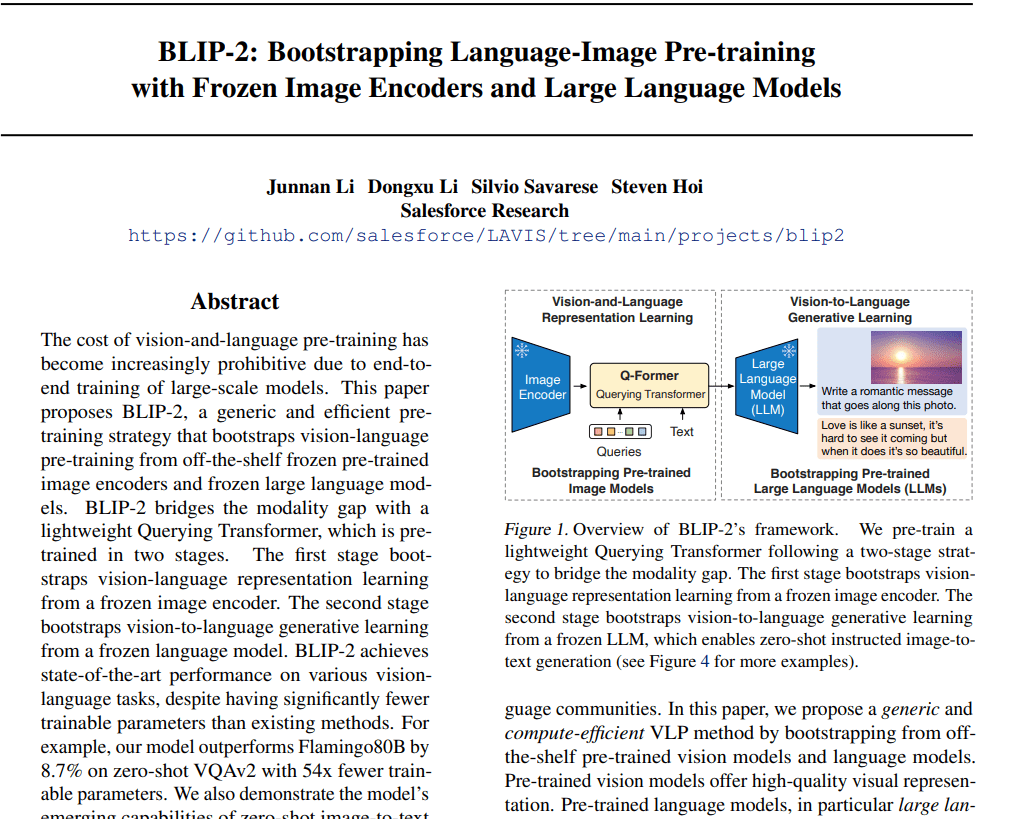

今年1月,Junnan Li发布了新模型BLIP-2,目前代码已开源,在Github上已获得3.5k星。BLIP-2包含了图像编码器和大型语言模型(LLM)的解码器,并附加了可将视觉转换到语言的Q-Former,其使用的通用预训练框架可以任意对接自己的语言模型。

论文显示,在零样本图像-文本生成、视觉问答、图像-文本检索、图像字幕任务等多项视觉语言任务的评估中,BLIP-2都实现了SOTA(研究任务中目前最好的性能和表现)。BLIP-2已具备图像信息检索、事实推理以及开放性生成问题等能力,而上文中的梗图生成器就是模型对于用户上传的图片进行上述任务处理的能力体现。

多模态大模型的下一站

当下,多模态大模型已在全球遍地开花。多模态预训练模型已开始向多模态通用生成模型转变,并有了一些初步的探索。除了上文中的GPT-4和BLIP-2以外,微软的Kosmos-1、谷歌的Flamingo、PaLM-E都是典型的多模态通用生成模型。

以上模型虽然可进行图像、文字等多模态输入,但其只能进行通用的语言生成。在此基础上,微软的VALL-E主打高质量的文本转语音。而“文生视频”则被视为多模态大模型的下一站,海内外多家科技公司已开始向视觉生成领域发起冲锋。

Meta的Make-A-Video可以把文字生成视频,也可以将静态图片生成连续图片并连接成一段视频;谷歌的两款文生视频产品中,Imagen Video主打高分辨率的高清视频片段,Phenaki基于新编解码器C-ViViT挑战有故事有长度的视频;曾参与奥斯卡获奖影片《瞬息全宇宙》特效制作的创业公司Runway发布的 Gen-1 模型可通过应用文本提示或者参考图像所指定的任意风格,将现有视频转换为新视频……

国内,百度的文心大模型开始提供文字生成视频功能、阿里达摩院的 “文本生成视频大模型”也在开源模型平台低调对外测试。

但总体而言,现有的文生视频模型效果还不太理想。因而,业界仍普遍期待OpenAI视觉生成能力的展现。当前,GPT-4的多模态能力仅限于图片处理,而GPT-5的视频处理能力则会将多模态的能力提升到可能接近人类的程度。

据预测,最快在今年6-7月,GPT-5的功能将陆续开放。除了更庞大的参数规模、更精准强悍的语言理解能力,GPT-5最具变革性的功能之一便是对包括音频和视频在内的多模态处理能力。未来,GPT-5创建和生成的内容将囊括文字、音频、3D模型和视频。

值得注意的是,在建立各种多模态大模型的过程中,通过生成指令微调使之与人类对齐是一大当务之急,否则模型将产生较多有害信息,降低其可用性。建立多模态大模型的意义在于不同让模态数据之间相互辅助与促进,使AI更好地感知和理解人类的情感和语言,提高其安全性与可靠性,从而更好地与人类进行交互和协作。