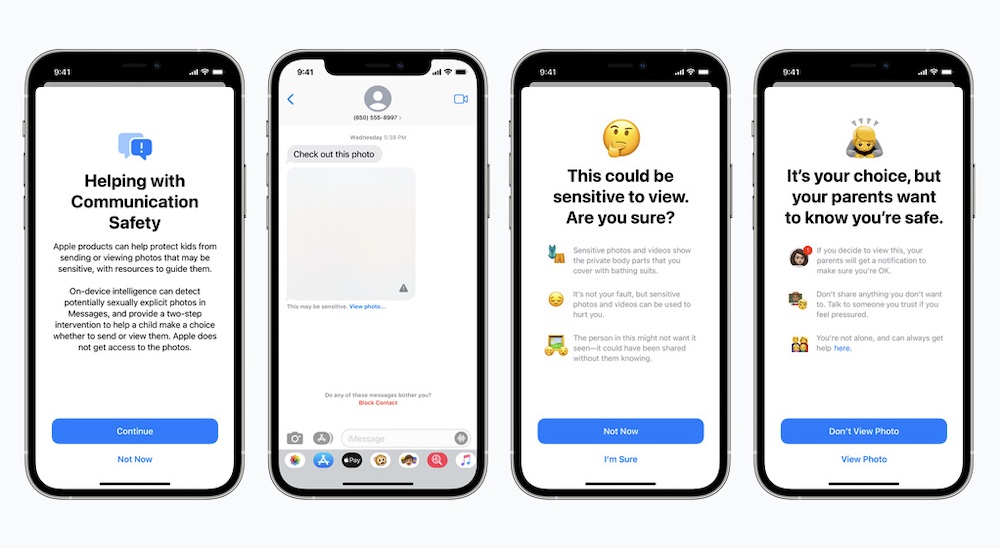

为了加强对儿童的保护,苹果公布了三项新举措:Messages 中的敏感图像筛查、iCloud 中儿童性虐待内容检测,以及Siri和搜索功能的相关内容帮助支持。

在苹果的信息应用 Messages 中,如果家庭用户中的儿童收到或尝试发送色情照片时,他们将看到一条警告信息。当孩子收到色情图片时,图片会变得模糊,Messages 应用会显示警告,称该图片「可能很敏感」。如果孩子点击查看照片,那么他们将会看到一条弹出消息,告知他们为什么该图像被判定为敏感。如果孩子决定查看图像,其设备关联的父母端将收到通知,弹窗将包含一个带有帮助信息的链接。

此外,如果孩子试图发送色情图片,他们会看到类似的警告。如果孩子选择发送照片,父母能收到一条消息。此功能适用于 13 岁以下的孩子。

苹果解释称,该功能是可选的。Messages 运用设备上的机器学习来分析图像,并判定照片是否含有色情内容。

第二个是儿童性虐待内容 (CSAM)检测。苹果会扫描存储在 iCloud 云端中的这类图像,并向美国国家儿童失踪与受虐儿童援助中心(NCMEC)报告实例。该公司会将NCMEC的数据库转换为一组不可读的哈希函数,之后进行对比。一旦匹配程度达到某一阈值,苹果将手动审查确认匹配,然后禁用帐户,并向NCMEC报告。

最后,Siri和搜索功能方面,苹果还通过提供额外资源帮助儿童和父母确保网上安全,如果在不安全的时候可通过Siri和搜索获取帮助指导。例如可询问Siri如何报告儿童性虐待内容,这些功能将告知用户在哪可以汇报给有关部门。

上述功能将首先在美国推出,今年晚些时候为 iOS 15、iPadOS 15和macOS Monterey 的 iCloud 家庭账户开放。